第七周 PLAYAROUD 國際工作坊

這是第三次參加工作坊,不過這次很特別的是,此工作坊的講師團隊是由PLAYAROUND外國講師所組成,他們在台北辦了一場為期7天的太空殖民工作坊,很高興在台中也夠舉辦,雖然只有一天,但也是新的一種體驗。

先說說一些前置作業好了,很開心能參予到工作坊的準備工作,處理報名以及整個活動的一些前置工作,說實在的準備時間有點匆忙,也是第一次擔任這樣的工作,難免有些小地方疏忽,感謝主任給了這次的經驗,讓我學習到許多進退之道以及做事方式。

當天工作坊,將講師們接待至會場準備開幕儀式,接著開始分組課程,我選擇了VVVV視覺音樂,因為對於音樂視覺化頗有興趣,相當期待課程的進行。

是一個開源程序語言及開發環境,提供給那些想要對影像、動畫、聲音進行程序編輯的學生、藝術家、設計師、研究員以及有興趣的人。vvvv可以免費地下載,支持的平臺是Windows。一個可做3D的軟體,也可跟processing做結合。

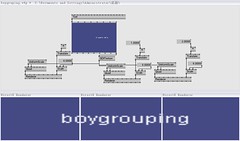

在 VVVV 的環境下沒有條列式的程序撰寫,其運作方式是將程序代碼集結成特定功能的程序組節點(Node),再進一步整合節點架構出整個視覺性的網絡系統。

它適用於許多任務,涉及常見計算機相關媒體如音頻,視頻,三維動畫,網絡…..。並且還能很方便的連接各種外部設備。

VVVV的特點有:

1. 能夠同時處理大量計數的物件,圖形或數據。控制單個圖形對象與1000個之間不會有明顯的差別,這種技術被稱為”Spreading”。

2. 無縫多媒體投影技術,這樣可以讓我們很容易的使用多臺投影儀進行超寬屏無縫投影,這個由一臺服務器統一控制任何數量的客戶端計算機的技術被稱為“Boygrouping”

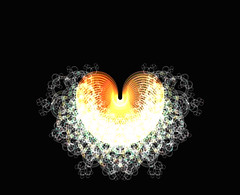

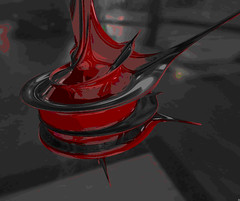

3. 基於DirectX的三維渲染,加載3D模型,3D紋理,實時著色,實時物理模擬。

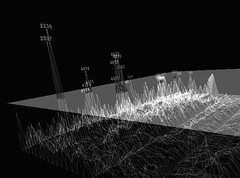

|

| DirectX的三維渲染 |

|

| DirectX的三維渲染 |

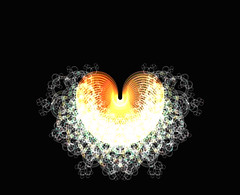

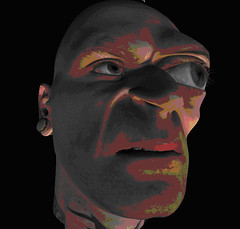

|

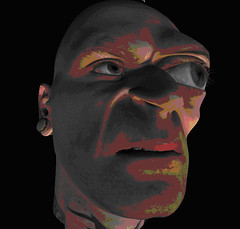

| 加載3D模型 |

|

| 實時著色 |

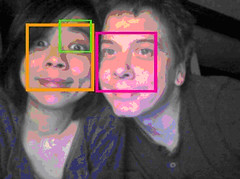

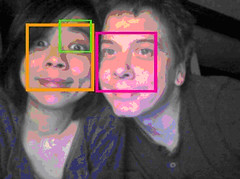

4. 實時視頻分析(光學追蹤),在4v裏可以同時或分別使用不同追蹤技術. 如:輪廓捕捉,色彩捕捉,運動檢測,二維碼識別等等。

|

| 實時視頻分析 |

5.音頻功能。vvvv的聲音引擎基於微軟的DirectShow技術,能夠播放絕大多數格式的音頻文件以及對多個音頻文件進行簡單的混合。而且運用FFT(傅立葉轉換)算法可以很方便的創作現場實時音視頻交互作品。

---------------------------------------------------------------------------------------------------------

vvvv這套軟體是我第一次聽到也是第一次使用,就是一種圖型化的程式工具,跟puredata有著相似的面貌,只需要一點的程式概念,就能"連出"有趣的作品。

講師Paul用簡單入門的範例來教學。

慢慢的越連越多程式方塊,可以更改顏色.大小。

還接上了麥克風,利用麥克風匯入的聲音變化去改變視覺畫面,我播放了流行音樂讓克風去接收,不同的旋律產生不同的視覺,初階的作品看起來滿像windows player的視覺波紋。

因為一開始在設備上出現了故障的情況,耽誤了許多時間,而Paul即時改變教學方式,讓我們在最短時間了解VVVV的基本功能,在這一天8小時的時間,雖然不是非常能夠完全吸收,但VVVV的魅力已經傳達到我們的腦中,由於VVVV是開放性的軟體,在網路上能可搜尋到許多資料,看著這麼各式各樣由VVVV創作的作品,完全可以說是用嘖嘖稱奇來形容了。

|

| 工作坊合照 |

|

| 組合照 |

|

| 與Paul合照 |

最後成果發表也欣賞了其他兩組的作品,都是不錯的科技藝術領域的新體驗,只可惜我的作品在課程後段某個程式方塊發生錯誤,無法及時回覆,沒辦法展現給大家觀賞,真是可惜。感謝所有協助人員以及系上,讓此工作坊辦的圓滿成功,希望下次能有機會再次舉辦。